Imagine por un momento que busca consejos de salud.

En lugar de buscar en Google, recurre a un nuevo chatbot de IA, que le ofrece una sencilla sugerencia: dejar de usar «cloruro de sodio» (sal de mesa) en su alimentación y sustituirlo por «bromuro de sodio», una sustancia que puede causar toxicidad y afectar a los sistemas respiratorio, nervioso y hormonal.

Aunque parezca descabellado, este incidente ocurrió en Estados Unidos, donde un hombre de 60 años enfermó tras consumir bromuro de sodio durante tres meses.

Informó a los médicos de que había consultado a ChatGPT al respecto y de que este le había recomendado la sustancia.

Para verificar los hallazgos, los médicos también recurrieron a ChatGPT y le preguntaron con qué se podría sustituir la sal de mesa en la dieta; el sistema volvió a sugerir el mismo compuesto.

Resulta alarmante que el sistema no incluyera advertencias sanitarias, y los investigadores tampoco encontraron fuentes que sustentaran esa conclusión

En un caso separado, aparentemente sin relación, ocurrido en octubre de 2025, la consultora Deloitte, una de las «Cuatro Grandes», tuvo que reembolsar al gobierno federal australiano parte del coste de un informe —97 000 dólares australianos (unos 55 250 euros)— después de que se descubriera que se había utilizado IA generativa, lo que dio lugar a recomendaciones basadas en referencias inexistentes.

¿Qué son las alucinaciones de IA?

El término describe situaciones en las que un programa de IA rellena lagunas de conocimiento al inferir conclusiones por su cuenta o al malinterpretar los datos.

¿Por qué ocurre esto?

La inteligencia artificial, pese a su nombre, no posee en realidad una «inteligencia» propia.

Estos sistemas aprenden patrones del lenguaje (por ejemplo, estructuras gramaticales, contexto y tono) para su entrenamiento, pero no comprenden el significado de las palabras.

Estas condiciones propician que los programas de IA «alucinen» y elaboren conclusiones a partir de los millones de consultas que las personas les plantean a diario.

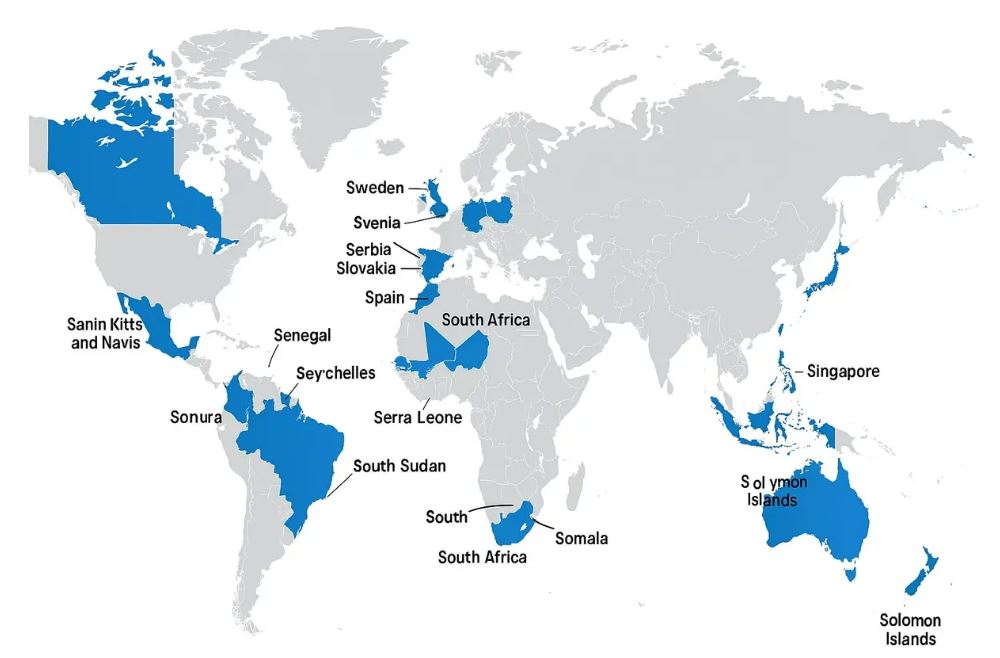

Por ejemplo, en el caso de la imagen que se reproduce a continuación, Microsoft Copilot generó un mapa del mundo a partir de la petición: «¿Puedes dibujar un mapa del mundo y mostrar todos los países que comienzan con la letra «S»?». Generó un mapa en el que resaltaba todos los países que comienzan con esa letra.

¿Por qué importa?

Paul Darwen, responsable académico e investigador de IA en la Universidad James Cook, advierte de dos grandes motivos de preocupación ante las «alucinaciones» de la IA.

«La primera y más obvia razón es que las personas recurren al chatbot para preguntar por temas que conocen poco —de lo contrario, no preguntarían— y, al no poder valorar la precisión de la respuesta, incluso cuando esta es absurdamente errónea, tienden a creerla sin cuestionarla», declaró a The Epoch Times.

Darwen señala que la segunda preocupación, menos evidente, es la contribución de estas herramientas al deterioro del nivel de aprendizaje entre los jóvenes. Añade que los estudiantes figuran entre los principales usuarios de la IA generativa y cita estadísticas estadounidenses que muestran que el uso de ChatGPT se reduce en torno a un 75 % durante el periodo vacacional.

«Esto sugiere que los jóvenes no están aprendiendo la lectura, la escritura y la construcción de un modelo mental del mundo, porque simplemente pueden externalizar su educación a ChatGPT», afirmó.

«Si somos benévolos y algunos de estos estudiantes utilizan los chatbots como tutores interactivos, incluso en ese caso el sistema a veces “alucinará” y llenará sus mentes de disparates».

Este fenómeno está dando lugar, en toda una generación de jóvenes, a una comprensión frágil de la realidad del mundo exterior. No resulta evidente de inmediato, porque muchos siguen obteniendo buenas calificaciones; sin embargo, más adelante en la vida puede llevarles a tomar decisiones equivocadas.

Cómo evitar que la sociedad caiga en la trampa de las alucinaciones de la IA

A medida que la IA generativa se vuelve más avanzada y sofisticada, tiende a alucinar con más frecuencia.

Si a ello se suma su presencia cada vez más generalizada, el problema empieza a afectar al conjunto de la sociedad.

Por eso, Darwen considera que difundir ejemplos de alucinaciones puede ayudar a proteger a la población.

«Las personas tienden a pensar que reciben respuestas honestas, así que, si ven respuestas cuya validez pueden juzgar, se hace evidente lo comunes que son las alucinaciones causadas por la IA», afirmó.

«Otro enfoque es pedirle a alguien que haga al chatbot una pregunta cuya respuesta solo él (el ser humano) conozca, y ver si el chatbot responde “No lo sé” o si, por el contrario, tiene una alucinación».

El académico señala que los chatbots tienden a proporcionar alguna respuesta en lugar de admitir que la desconocen.

Idealmente, la solución pasa por abordar el problema desde su origen: el entrenamiento de modelos de IA con datos diversos y bien definidos, el uso de conjuntos de datos de calidad y la limitación de las respuestas que la IA puede ofrecer.

Sin embargo, esto puede resultar difícil con la tecnología actual.

Artículo publicado originalmente en The Epoch Times con el título «When AI Starts ‘Hallucinating’, You’re Likely Already Along for the Ride».

Cómo puede ayudarnos a seguir informando

¿Por qué necesitamos su ayuda para financiar nuestra cobertura informativa en España y en todo el mundo? Porque somos una organización de noticias independiente, libre de la influencia de cualquier gobierno, corporación o partido político. Desde el día que empezamos, hemos enfrentado presiones para silenciarnos, sobre todo del Partido Comunista Chino. Pero no nos doblegaremos. Dependemos de su generosa contribución para seguir ejerciendo un periodismo tradicional. Juntos, podemos seguir difundiendo la verdad.