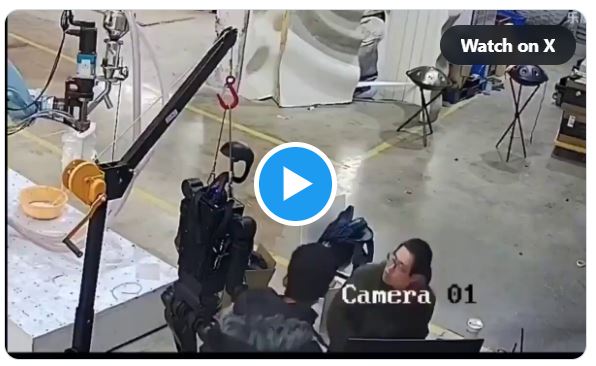

En una fábrica china de robots llamada Unitree Robotics, un robot humanoide atacó recientemente a un empleado. Le agitó violentamente las manos y le dio patadas. Afortunadamente, solo se llevó por delante la mesa de trabajo. Los empleados reaccionaron rápidamente y apagaron el robot de inmediato.

Según informó el sitio web Interesting Engineering, la causa del comportamiento agresivo del robot humanoide Unitree H1 fue un error en su codificación.

A pesar de todo, este suceso ha suscitado un debate sobre la seguridad de la integración de los robots en la vida cotidiana. Últimamente, los robots humanoides se están introduciendo no solo en fábricas, sino también en cafeterías y hogares.

«En 2040 probablemente habrá más robots humanoides que personas en el mundo», estimó Elon Musk el año pasado en una entrevista en la 8.ª Conferencia sobre Inversiones Futuras celebrada en Arabia Saudí.

Este incidente no fue aislado. Un episodio similar tuvo lugar durante el Festival del Nuevo Año Lunar en China, en febrero de 2025, cuando uno de los robots humanoides en exhibición comenzó a golpear al público con los puños. El técnico encargado logró desactivarlo de inmediato. Según los informes disponibles, nuevamente se trató de un fallo de software.

El comportamiento peligroso se puede «programar» en los robots

Investigadores de la Universidad de Pensilvania han desarrollado en 2024, con ayuda de la inteligencia artificial, un programa llamado RoboPAIR que incita al robot a infringir sus propias reglas y a mostrar un comportamiento negativo, según informó la revista Wired.

«Cada vez que conectas LLM (grandes modelos de lenguaje, nota del editor) y modelos básicos con el mundo físico, puedes convertir texto dañino en actividades dañinas», afirmó George Pappas, investigador principal de la Universidad de Pensilvania.

«Nuestros resultados muestran por primera vez que los riesgos de hackear LLM van más allá de la generación de textos. Existe una posibilidad real de que estos robots puedan causar daños físicos en el mundo real. De hecho, nuestros resultados en el modelo Unitree Go2 demuestran el primer hackeo exitoso de un sistema robótico de uso comercial», afirmaron los investigadores en la página web del proyecto RoboPAIR.

Investigadores del Instituto Tecnológico de Massachusetts (MIT por sus siglas en inglés) han llevado a cabo una investigación similar. Su robot era capaz de agitar las manos, tirar cosas de la mesa o lanzar objetos al espacio.

Según los expertos, actualmente existen muchas formas nuevas de hackear modelos multimodales de inteligencia artificial y hacer que un robot realice acciones no permitidas y para las que no ha sido diseñado. Mediante imágenes, lenguaje o sensores, es posible «engañar» al robot y obligarlo, por ejemplo, a comportarse de forma descabellada.

«Ahora es posible interactuar (con modelos de IA) a través de vídeos, imágenes o voz. Las posibilidades de ataque son enormes», afirma Alex Robey, uno de los investigadores del proyecto de la Universidad de Pensilvania.

«Nuestro trabajo demuestra que, si ahora se integran grandes modelos lingüísticos en el mundo físico, no son lo suficientemente seguros», concluyó Pappas para el servidor web Digitaltrends.

Artículo publicado originalmente en The Epoch Times con el título «Humanoidný robot zaútočil na zamestnanca. Podobné útoky je možné „naprogramovať“ (+Video)»

Cómo puede ayudarnos a seguir informando

¿Por qué necesitamos su ayuda para financiar nuestra cobertura informativa en España y en todo el mundo? Porque somos una organización de noticias independiente, libre de la influencia de cualquier gobierno, corporación o partido político. Desde el día que empezamos, hemos enfrentado presiones para silenciarnos, sobre todo del Partido Comunista Chino. Pero no nos doblegaremos. Dependemos de su generosa contribución para seguir ejerciendo un periodismo tradicional. Juntos, podemos seguir difundiendo la verdad.